Testowanie oprogramowania antywirusowego wcale nie jest prostą sprawą. Wystarczy tylko spojrzeć na metodykę AV-Comparatives by przekonać się, że każde badanie to proces żmudnych obliczeń, proces, który wymaga specjalistycznej wiedzy z zakresu działania oprogramowania, wirusów, systemów oraz sieci. Oczywiście bardzo dobrze, że takie laboratoria istnieją, lecz nie zawsze przedstawiane wyniki są nad wyraz rzetelne. Dlatego jako niezależny polski lab zawsze powtarzamy, że wybór oprogramowania antywirusowego powinien być poprzedzony opinią wdrożonych z temat security kolegów oraz własną analizą publikowanych raportów.

Obecnie programy antywirusowe przeżywają mały kryzys. Nie ze względu na zastój spowodowany załamaniem gospodarczym, ale na postępujące metody szyfrowania danych, które wykorzystywane są przez autorów złośliwego oprogramowania oraz samą ich ilość, która liczona jest w setkach tysięcy każdego dnia. Oczywiście, złośliwi mogą powiedzieć, że od tego są sygnatury generyczne i algorytmy heurystyczne poszukujące wszelakich anomalii, które odbiegają od normy „zachowania” się pliku w systemie. No i tak – mamy zaawansowane technologie wykrywające malware w systemie, dwukierunkowe firewalle z funkcją DLP i IPS, rozwiązania antyspamowe bazujące na serwerach RBL (Realtime Blackhole List) i SURLB (Spam URL Realtime Blacklist), filtry internetowe skanujące strony w czasie rzeczywistym pod kątem szkodliwego kodu i plików, HIPS-y, monitory bahawioralne, piaskownice… Ale to wszystko jest ciągle za mało, nadal czegoś brakuje, jakiegoś spoiwa, którym jest niewątpliwie wiedza z zakresu bezpieczeństwa komputerowego. Ale czy wszyscy mogą i czy muszą ją posiąść? Wydaje się, że tak, a przynajmniej w stopniu podstawowym.

Jak wybrać ten „najlepszy” antywirus?

Słowo „najlepszy” celowo zostało podkreślone. Niestety ten „najlepszy” nie istnieje i długo jeszcze nie powstanie – z bardzo oczywistego powodu. Producenci antywirusów zawsze reagują na nowe wektory ataków już po fakcie. Ale czemu mamy się im dziwić? W końcu nikt nie przewidzi ludzkiej kreatywności i pomysłowości w wymyślaniu nowych technik penetracji systemów i sieci.

Jeśli jednak nadal nie znamy odpowiedzi na nurtujące pytanie dotyczące wyboru antywirusa, zawsze warto zaczerpnąć tą wiedzę od bardziej wdrożonych w temat kolegów lub samemu analizując wyniki z różnych testów. I tutaj dochodzimy do sedna sprawy, a konkretnie metodologii niemieckiego laboratorium AV-TEST.

Metodologia testów AV-TEST

Wykorzystywane narzędzia

1. SUNSHINE – to opracowany przez AV-TEST analityczny system, który podczas testów sprawdza, czy komputer został już zainfekowany, czy jeszcze nie. Sunshine umożliwia testerom zautomatyzowanie żmudnego procesu testowania aplikacji antywirusowych w sposób kontrolowany i z góry przewidziany. Sunshine monitoruje następujące obszary systemowe:

- System plików (tworzenie, modyfikacja, usuwanie),

- Rejestr (tworzenie, modyfikacja, usuwanie kluczy i wartości),

- Procesy i ich moduły,

- Pamięć systemową,

- Ruch sieciowy przychodzący i wychodzący.

2. VTEST – jest uniwersalnym skanerem antywirusowym dla systemów Windows i Android. Rozsiany po całym świecie w różnych miejscach geograficznych wydaje się być połączeniem honeypota z zaawansowanym systemem kilkudziesięciu skanerów antywirusowych (coś na wzór VirusTotal), dzięki którym wykrycie znanych wzorców wirusów przebiega znacznie szybciej. VTEST codziennie skanuje wiele milionów plików, w pełni automatycznie, w sposób terminowy i efektywny.

3. FLARE – to baza danych AV-TEST, która gromadzi informacje o milionach zagrożeń. W połączeniu z VTEST i Sunshine jest ona wykorzystywana do odseparowywania fałszywych próbek od prawdziwych wirusów.

Korelacja tych wszystkich autorskich narzędzi pozwala przygotować do testu odpowiednią „jakość” i ilość złośliwego oprogramowania.

Metodologia przed Q1 2013

Rozwiązanie zabezpieczające powinno charakteryzować się bardzo dobrą wykrywalnością i skutecznością (wykrywalność ≠ skuteczność), wydajnością oraz użytecznością, a więc zainfekowany system powinien zostać całkowicie wyleczony, z kolei na mocno zainfekowanym komputerze oprogramowanie antywirusowe powinno dać się zainstalować – a nie zawsze jest to możliwe. Nie bez znaczenia są także wystąpienia fałszywych alarmów, które wpływają na obniżenie końcowej oceny.

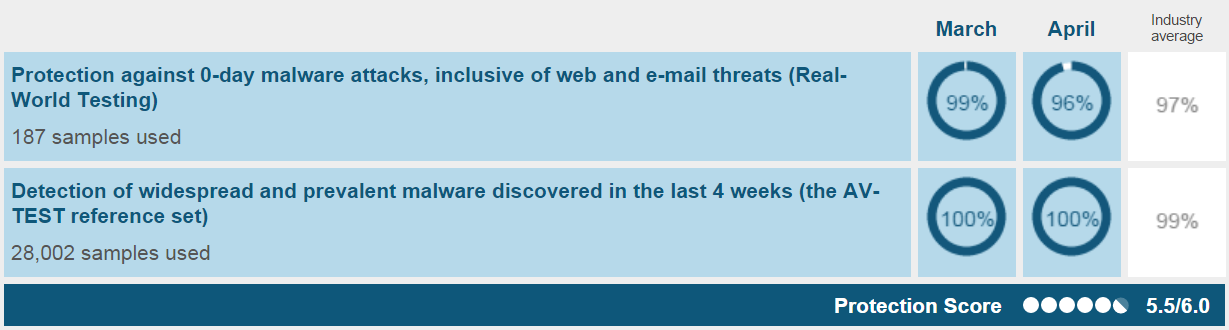

1. Ochrona (protection)

AV-TEST do każdego testu wykorzystuje około 200 malware zero-day, kilkadziesiąt tysięcy wirusów skompletowanych do 4 tygodni przed testem, które pochodzą ze spamu, sieci Internet oraz systemów VTEST rozsianych po całym świecie.

1.1 Programy antywirusowe instalowane są na domyślnych ustawieniach, następnie aktualizowane są do najnowszych wersji łącznie z bazą sygnatur wirusów. Posiadają także stały dostęp do Internetu przez cały okres badania – w ten sposób wszystkie moduły ochronne antywirusa mogą w pełni korzystać ze swoich możliwości – statyczna/dynamiczna analiza w chmurze, sygnatury w chmurze, reputacji plików, stron www, odpytywanie serwerów RBL/SURLB, reputacja hostów IP, itp.

1.2 Następnie antywirusy w jednym czasie próbują uzyskać dostęp do złośliwej witryny lub e-maila.

1.3 Jeśli program zablokuje stronę i wyświetli komunikat zostaje to zarejestrowane. Warto wiedzieć, że niekoniecznie witryna musi zostać zablokowana, wystarczy, że komunikat zwróci wynik dla:

- Zablokowanej strony,

- Zablokowanego exploita,

- Zablokowanego pobieranego pliku lub szkodliwego komponentu.

1.4 Jeśli zagrożenie dostanie się do systemu, narzędzie Sunshine sprawdzania, czy system został zainfekowany i jakich zmian dokonało malware.

Powyższa procedura realizowana jest dla wszystkich testowanych programów antywirusowych jednocześnie. Dzięki temu test „porównawczy” przebiega na tych samych zasadach, w tym samym czasie, więc jest sprawiedliwy dla każdego producenta.

Warto tutaj jeszcze wspomnieć, że test ochrony dzieli się na dwie części. Pierwsza z nich określa skuteczność blokowania malware zero-day, natomiast druga odpowiada za wykrywalność statycznych próbek, których zazwyczaj jest około 30 tysięcy (skanowanie na żądanie). Wszystkie próbki wykorzystywane w teście są skolekcjonowane przez AV-TEST i sprawdzone pod kątem „jakości”. Z podanych informacji wynika też, że producenci antywirusów nie dostarczają własnych próbek do testów (w odróżnieniu od AV-Comparatives).

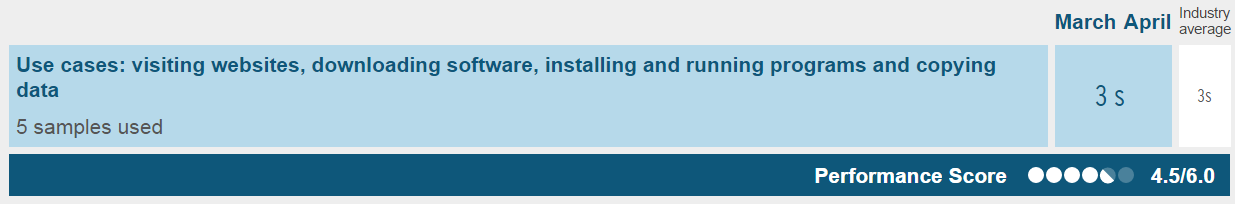

2. Wydajność (performance)

Optymalizacja wykorzystania zasobów systemowych – pamięci, procesora, procesu aktualizacji jest ważnych czynnikiem w procesie projektowania aplikacji. Tylko skuteczny, a zarazem wydajny program antywirusowy sprawdzi się w 100 procentach w systemie.

AV-TEST sprawdzając wydajność bierze pod uwagę 13 czynników, z czego oficjalnie wymienia tylko pięć:

- Czas pobierania plików z sieci,

- Czas kopiowania plików z/do sieci lokalnej,

- Czas instalacji programów,

- Czas uruchamiania aplikacji np. Word, Excel,

- Zużycie zasobów podczas korzystania z w/w aplikacji.

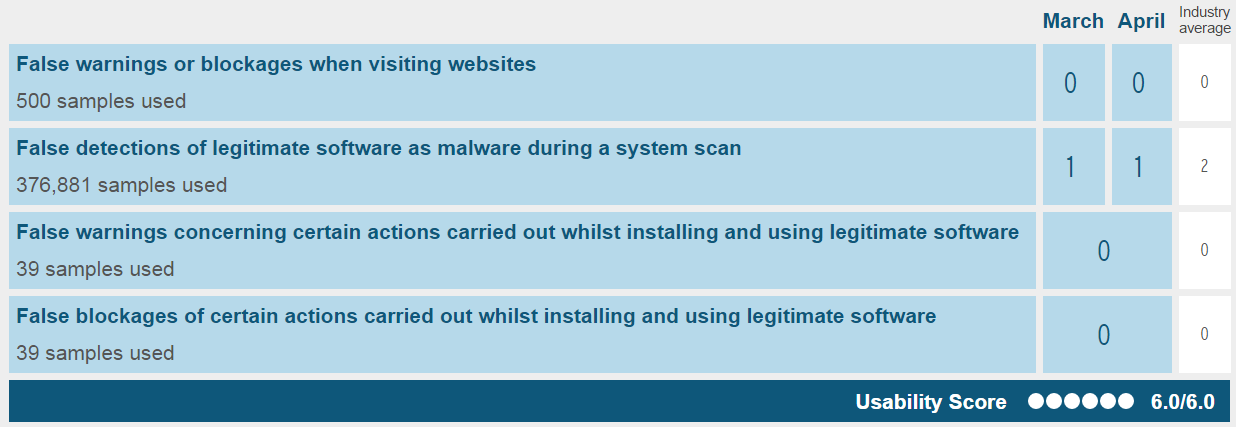

3. Użyteczność, przydatność (usability)

Nie chodzi tutaj o to, jakie funkcje oferuje program antywirusowy, lecz o:

- Fałszywe alarmy spowodowane zablokowaniem bezpiecznej witryny,

- Fałszywe wykrycia czystego oprogramowania jako wirusa podczas skanowania systemu,

- Fałszywe ostrzeżenia dotyczące niektórych czynności wykonywanych podczas instalowania i korzystania z legalnego oprogramowania,

- Fałszywe alarmy (blokowanie) dotyczące niektórych czynności wykonywanych podczas instalowania i korzystania z legalnego oprogramowania.

AV-TEST, aby sprawdzić jaką ilość fałszywych alarmów generuje testowane oprogramowanie wykorzystuje do tego celu zwykłe aplikacje takie jak Mozilla Firefox, Adobe Reader i Flash, Java, VLC Media Player oraz inne. Lista tych aplikacji jest zmieniana dla każdego testu po to, by producent nie przygotował się wcześniej na taką próbę.

Ponadto system Sunshine sprawdza, czy aplikacja została w pełni i poprawnie zainstalowana i czy wszystkie jej funkcje są dostępne. Jeśli tak nie jest, może to oznaczać, że pewien element został zablokowany. Sunshine zwraca wynik dla jakich programów wyświetlono komunikaty ostrzegawcze przez antywirusa i jak wiele z tych programów (lub częściowo) zostało zablokowanych.

4. Naprawa systemu (Repair)

Badanie to było charakterystyczne dla AV-TEST jeszcze kilka lat temu. Odróżniało ono amatorskie testy od tych profesjonalnych. Było bardzo cenione przez użytkowników i producentów (oczywiście tych, którzy zdobywali najlepsze noty). Jednak od końca 2012 roku AV-TEST przeprowadza te testy co kilka miesięcy i nie są one już jednolitą procedurą testową comiesięcznych publikowanych raportów.

- Programy instalowane są na domyślnych ustawieniach, następnie są aktualizowane do najnowszych wersji i baz sygnatur wirusów.

- Ochrona w czasie rzeczywistym zostaje wyłączona po to, by malware mogło zainfekować system.

- Następnie do akcji wkracza Sunshine i sprawdza, jakie zmiany w systemie spowodowała infekcja – np. tworzenie, usuwanie, modyfikacja plików, rejestru.

- System zostaje zrestartowany oraz uruchamiane jest pełne skanowanie systemu.

- Jeśli zajdzie taka potrzeba, system jest restartowany tyle razie, ile jest to konieczne.

- Czy infekcja została usunięta i w jakim stopniu ponownie decyduje o tym Sunshine.

Metodologia po Q1 2013

W pierwszym kwartale 2013 roku AV-TEST z bliżej nieokreślonych powodów zmodyfikował proces testowania oprogramowania antywirusowego dla użytkowników domowych oraz firm. Niestety, ale wprowadzone zmiany nie były na lepsze, spowodowały one, że obecnie przyznawane nagrody (czyt. certyfikaty) są delikatnie mówiąc naciągane. Oczywiści mowa tutaj o produktach, które nie osiągają najlepszych wyników w poszczególnych kategoriach (ochrona, wydajność, użyteczność).

Aby zobrazować jak zmiana kryteriów oceny wpłynęła na „jakość” przyznawanych certyfikatów wystarczy zapoznać się z poniższą, krótką analizą:

Dwa produkty, które otrzymały certyfikat potwierdzający skuteczność ochrony (protection) mogą zdecydowanie różnić się od siebie nie tylko pod względem posiadanych funkcji, ale przede wszystkim pod względem uzyskanego wyniku w teście na ochronę.

Przyjrzyjmy się badaniu z kwietnia 2015 roku: http://www.av-test.org/en/antivirus/home-windows/ – kolumna protection oraz certyfikaty z górny na dół.

W teście tym Avira Antivirus Pro 215 na 187 próbek malware zero-day zatrzymała 96% w marcu, 100% w kwietniu oraz 100% podczas skanowania na żądanie 28002 próbek.

Popatrzmy teraz na przedostatni wynik. Testowany w tym samym czasie ThreatTrack VIPRE Internet Security 2015 w marcu zatrzymał 80% malware zero-day, w kwietniu 81%. Podczas skanowania on-demand wykrył 100% statycznych zagrożeń. Zarówno Avira jak i VIPRE otrzymały ten sam certyfikat AV-TEST, jednak w przypadku nieznanych wirusów różnica jest naprawdę duża.

Sęk w tym, że VIPRE Internet Security 2015 w teście na ochronę otrzymał tylko 3 punkty na 6, a Avira 6/6. Jeśli też weźmiemy pod uwagę ogólny końcowy wynik, to różnica jest już znacząca – 18pkt. (maksymalnie) vs. 10 pkt. na korzyść niemieckiego producenta.

Przed rokiem 2013 program antywirusowy, aby zdobyć certyfikat musiał osiągnąć sumaryczny wynik na poziomie 15 punktów lub więcej, po wyrzuceniu z metodologii testu „na leczenie” wystarczy, że program zdobędzie 10 punktów i otrzyma certyfikat AV-TEST.

Dzisiaj

Niestety, ale naszym zdaniem certyfikat AV-TEST nie jest już tak prestiżowy jak dawniej. Wprawdzie AV-TEST publikuje od czasu do czasu testy „na leczenie”, jednak nie ma on nic wspólnego z przyznawanymi certyfikatami.

- Jakie „zagrożenia” niesie ze sobą zmiana przyznawania certyfikatów?

A no liczba producentów znacznie zwiększyła się – wcześniej, niektórzy dostawcy świadomie nie brali udziału w testach, ponieważ dobrze wiedzieli, że ich produkty nie sprostają tak rygorystycznym badaniom. Okazuje się także, że aby zdobyć certyfikat AV-TEST wystarczy zakupić silnik antywirusowy firmy trzeciej, powiązać go z multiskanerami takimi jak VirusTotal, korygować fałszywe alarmy na podstawie sum kontrolnych MD5, dodać moduł aktualizacji oraz kilka dodatkowych funkcji i gotowe – certyfikat gwarantowany.

Jednak z drugiej strony czy możemy się dziwić AV-TEST? Samo utrzymanie potrzebnej infrastruktury, nie mówiąc już o stworzeniu jej oraz opracowaniu odpowiednich narzędzi jest bardzo niepewną i kosztowną inwestycją. Obniżenie progu certyfikatów na pewno pozwoli większej ilości producentów dołączyć do testów oraz więcej zarobić pracownikom AV-TEST. Szkoda tylko, że AV-TEST kilka lat temu, kiedy antywirusy stały na progu ewolucji technologicznej nie postarał się o zdecydowanie lepszą metodologię, zapewne wszystkie środki przeznaczono na całkowitą automatyzację testów pozostawiając stopień skomplikowania metodologii na poziomie dużo niższym niż można było to osiągnąć. Zamiast postępu mamy więc regres i wątpliwą jakość certyfikatów.

Pamiętajcie drodzy czytelnicy, że certyfikat AV-TEST certyfikatowy jest nierówny.

Czy ten artykuł był pomocny?

Oceniono: 0 razy