Dokument został opracowany na zlecenie kierownictwa Departamentu Obrony USA przez grupę ekspertów, pracowników IT globalnych korporacji oraz zatrudnionych profesorów przez techniczne uczelnie wyższe. Raport pod tytułem „AI Principles: Recommendations on the Ethical Use of Artificial Intelligence by the Department of Defense” odnosi się do używania sztucznej inteligencji w wojskowości i projektach cywilnych. Dokument jest zestawieniem wytycznych na temat wdrażania i używania SI, „zanim dojdzie do incydentu”.

Najważniejsze wnioski, na które wskazują eksperci:

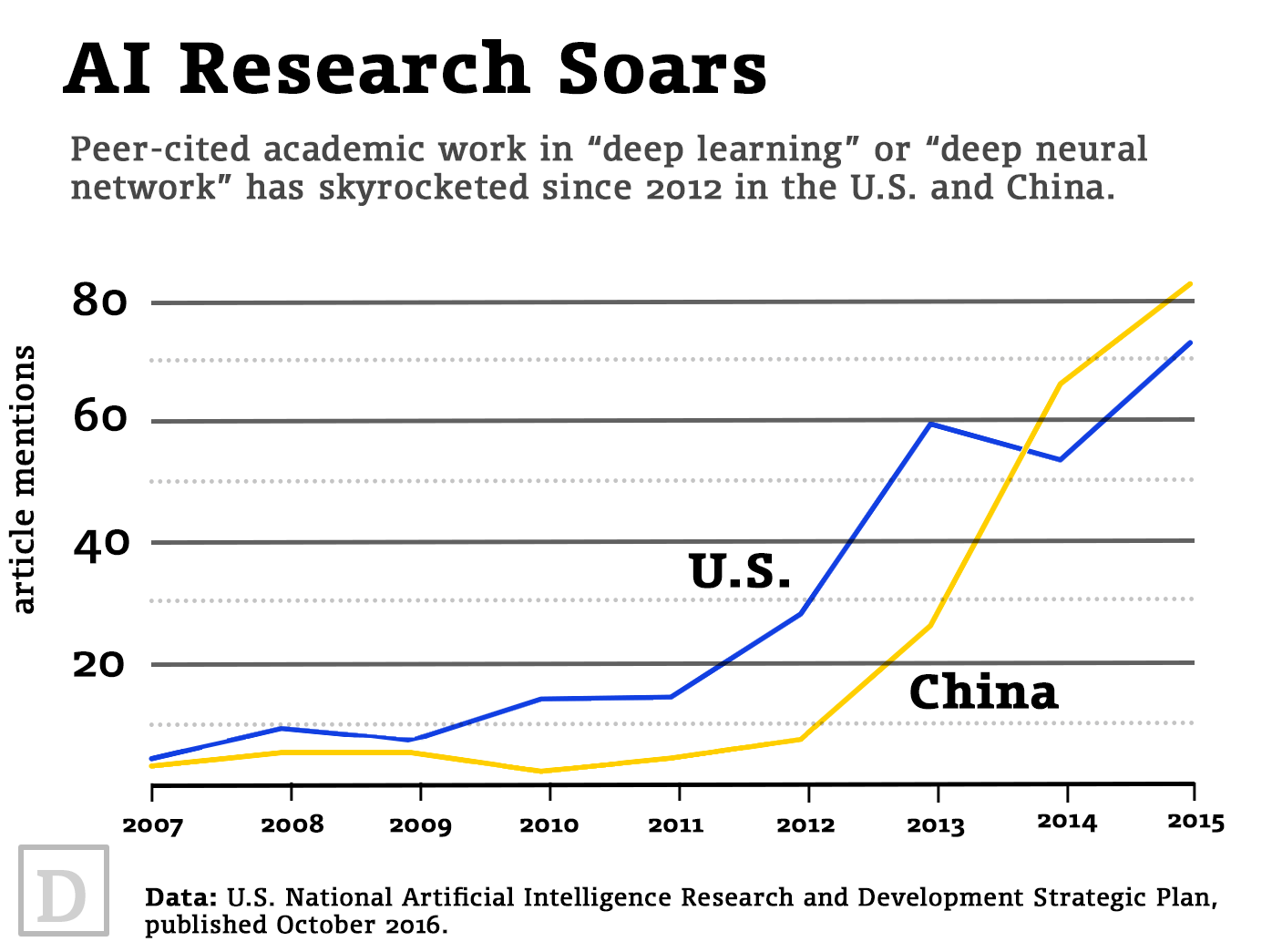

- USA już teraz obawia się o zwiększającą się przewagę technologiczną w pracach nad sztuczną inteligencją na rzecz Chin i Rosji.

- Ludzie powinni wiedzieć jakie pozytywne efekty ma wypracować sztuczna inteligencja w danym projekcie.

- Systemy AI nie powinny szkodzić ludziom.

- Algorytmy AI powinny być przejrzyste i możliwe do kontrolowania.

- Projektanci systemów SI powinni na wczesnym etapie definiować zakres działania technologii. Nie można wykraczać poza inne obszary.

- Ludzie powinni mieć możliwość kontrolowania SI w dowolnym momencie. W razie konieczności powinni mieć możliwość jej wyłączenia.

Wytyczne dla wojskowości i cywilnych obszarów gospodarki zawierają również zalecenia w zakresie inwestowania w technologie sztucznej inteligencji, stworzenia pomiarów niezawodności, a także zarządzania ryzykiem w przypadku incydentów.

Pozostałe badania zlecone przez Departament Obrony są dostępne na stronie: https://innovation.defense.gov

Sztuczna inteligencja w cuglach

Armia amerykańska nie wyjaśnia polityki dotyczącej prac badawczych nad sztuczną inteligencją, ale oficjalnie wiadomo, że sprawdza wykorzystanie tej technologii w zastosowaniach wojskowych.

Decyzja Departamentu Obrony USA zlecająca ekspertom z zewnątrz opracowanie wytycznych na temat wdrażania i używania SI może być mydleniem oczu. Pracownicy Google już dawno protestowali przeciwko wykorzystaniu sztucznej inteligencji w projekcie Maven, który mieli opracować dla Pentagonu. Projekt dotyczył ulepszenia wojskowych dronów przy użyciu sztucznej inteligencji.

Tymczasem Departament Obrony od wielu lat pracuje nad systemem zaawansowanego automatycznego namierzania i zabijania (ATLAS). Technologia wdrożona w dowolnym pojeździe porówna dane z wielu czujników, być może nawet z wielu pojazdów. Stworzy mapę najbardziej niebezpiecznych celów, następnie zidentyfikuje je na polu walki i wskaże załodze położenie wroga, którego należy wyeliminować w pierwszej kolejności. Ilość szczegółów z czujników będzie zależała od konkretnego algorytmu. Daje to możliwość potencjalnego wykorzystania SI na polu walki bezpośrednio pomiędzy żołnierzami wrogich armii.

Od pewnego czasu trwa debata na temat wykorzystania sztucznej inteligencji w zastosowaniach wojskowych. Już w 2015 r. na łamach ONZ zastanawiano się, czy SI może być używana jako broń. Od tego czasu w siłę urosła kampania STOP KILLER ROBOTS, która zwraca uwagę na niemoralne wykorzystanie sztucznej inteligencji do działań wojskowych przez rządy USA, Chin, Izraela, Południowej Korei, Rosji i Wielkiej Brytanii. Krótki filmu instruktażowy jest na stronie internetowej https://www.stopkillerrobots.org

Czy ten artykuł był pomocny?

Oceniono: 0 razy